Costruzione Soppalchi in Acciaio Val Brembilla

[meta_descrizione_seo]

Costruzione Soppalchi in Acciaio Val Brembilla

Aumentare lo spazio disponibile senza dover ampliare un edificio è possibile, pratico e vantaggioso. Il nostro servizio di costruzione soppalchi in acciaio su misura offre una soluzione solida, sicura e completamente personalizzabile per sfruttare al massimo il volume in altezza di locali industriali, commerciali e residenziali.

I soppalchi in acciaio sono ideali per creare nuovi ambienti di lavoro, depositi, zone ufficio o aree tecniche sopraelevate, con strutture modulari ad alta resistenza e adattabili a ogni tipo di esigenza. Progettiamo, realizziamo e montiamo soppalchi certificati, pronti all'uso e pensati per durare nel tempo.

Cosa realizziamo:

-

Soppalchi industriali per magazzini, officine, capannoni

-

Soppalchi portanti per carichi elevati, scaffalature o impianti

-

Soppalchi per uffici interni o zone operative rialzate

-

Strutture con scale, parapetti, cancelli di sicurezza e rampe

-

Pavimentazioni in lamiera grecata, grigliato o legno tecnico

-

Soppalchi per ambienti commerciali e residenziali

Caratteristiche del servizio

-

Progettazione personalizzata secondo le dimensioni e il carico richiesto

-

Calcoli strutturali e disegni tecnici eseguiti da personale qualificato

-

Strutture in acciaio zincato o verniciato, resistenti alla corrosione

-

Sistemi di ancoraggio, rinforzo e sicurezza certificati

-

Montaggio rapido, preciso e senza interventi invasivi

-

Predisposizione per impianti elettrici, luci, divisori o scaffalature

Ogni soppalco viene studiato per integrare perfettamente funzionalità, sicurezza e ottimizzazione degli spazi, con un occhio di riguardo alla praticità quotidiana e alle normative vigenti.

A chi è rivolto questo servizio

-

Aziende che vogliono ottimizzare il magazzino o aumentare lo spazio operativo

-

Officine e laboratori che necessitano di superfici calpestabili aggiuntive

-

Negozi e showroom che desiderano aree espositive sopraelevate

-

Privati con locali alti da valorizzare (garage, loft, depositi)

-

Studi tecnici e imprese che cercano un partner per realizzazioni su misura

Perché scegliere un soppalco in acciaio?

-

Aumento dello spazio utilizzabile senza interventi strutturali invasivi

-

Soluzione robusta, modulare e facilmente smontabile o ampliabile

-

Adatta a ogni tipo di ambiente: industriale, commerciale o civile

-

Massima resistenza ai carichi statici e dinamici, anche pesanti

-

Installazione rapida, con tempi certi e costi controllati

📌 Ogni metro in altezza può diventare valore aggiunto.

Contattaci per progettare insieme un soppalco in acciaio funzionale, sicuro e su misura per i tuoi spazi.

Alcuni Articoli Dai Nostri Giornali:

Opere Metalliche

Benvenuto nella rubrica dedicata ai soppalchi in acciaio, un mondo di soluzioni funzionali e robuste per ottimizzare gli spazi.

Qui troverai approfondimenti tecnici, esempi pratici e consigli per progettare e realizzare soppalchi sicuri, resistenti e su misura.

Scorri gli articoli e lasciati guidare dalla nostra esperienza nel campo della carpenteria metallica.

Scopriamo insieme il magico mondo dei rifugi urbani, veri e propri spazi di respiro nel caos cittadino. Un connubio perfetto tra natura e arte che trasforma le città in veri gioielli urbani.

- « Precedente

- 1

- …

- 14

- 15

- 16

FAQ

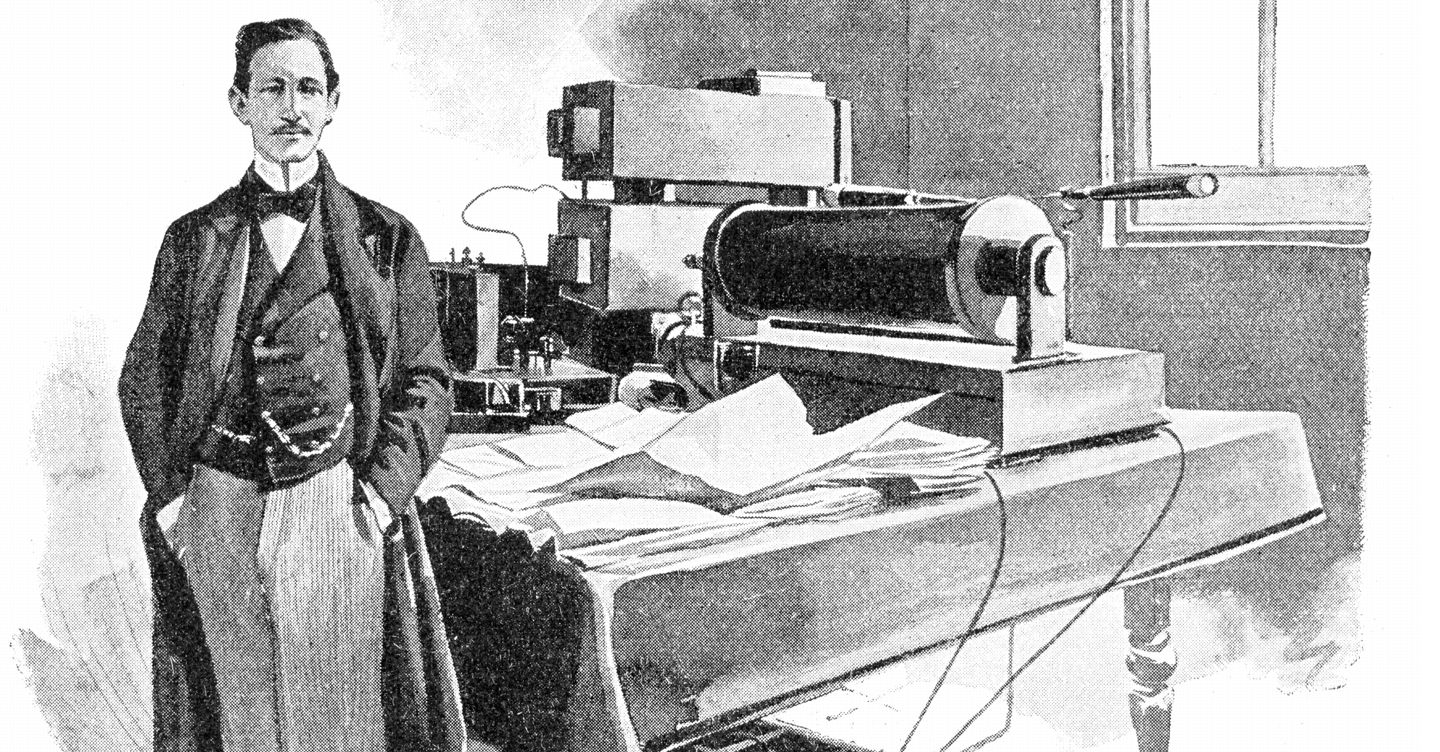

C’è un suono che ancora oggi risuona. Non è un semplice clic su uno schermo, ma il suono della trasmissione radiofonica, un’invenzione che ha rivoluzionato il mondo grazie a Guglielmo Marconi. Nato a Bologna nel 1874, Marconi è stato un inventore e imprenditore italiano che ha contribuito in modo significativo allo sviluppo delle comunicazioni wireless.

Marconi è noto per aver realizzato la prima trasmissione radiofonica senza fili nel 1895, utilizzando l’onda elettromagnetica per inviare segnali a distanza. Questa invenzione ha aperto la strada alla comunicazione globale, consentendo alle persone di comunicare istantaneamente attraverso grandi distanze.

L’eredità di Marconi è ancora viva oggi, con la radio che continua a essere uno dei mezzi di comunicazione più diffusi al mondo. La sua invenzione ha anche gettato le basi per lo sviluppo della tecnologia wireless moderna, come il Wi-Fi e il Bluetooth.

Oltre alla sua importanza nel campo delle comunicazioni, Marconi ha anche ricevuto il Premio Nobel per la fisica nel 1909 per i suoi contributi all’invenzione della radio. La sua genialità e il suo spirito innovativo hanno lasciato un’impronta duratura sulla storia della tecnologia e delle comunicazioni.

Benvenuti alla rassegna sulle gare di appalto per le costruzioni edili dove, vi forniamo una panoramica sui progetti futuri a breve e delle scadenze per la presentazione.

Nella settimana dal 28 giugno 2024 al 5 luglio 2024, in Italia sono state bandite diverse gare di appalto per progetti di costruzione edile. Ecco una panoramica dettagliata con informazioni schematizzate per ciascun progetto:

1. Regione Lombardia

Progettazione e realizzazione di una scuola primaria a Milano

| Dettaglio | Informazione |

|---|---|

| Scadenza offerte | 2 luglio 2024 |

| Importo a base d’asta | 5 milioni di euro |

| Descrizione | Costruzione di una nuova scuola primaria con tutte le infrastrutture necessarie per l’educazione dei bambini. Include progettazione, costruzione e fornitura di arredi scolastici e attrezzature didattiche. |

2. Regione Lazio

Riqualificazione di un edificio storico a Roma

| Dettaglio | Informazione |

|---|---|

| Scadenza offerte | 4 luglio 2024 |

| Importo a base d’asta | 3,5 milioni di euro |

| Descrizione | Restauro e adeguamento funzionale di un edificio di rilevanza storica, mirato a preservare l’integrità storica mentre lo rende funzionale per nuovi usi (spazi pubblici, musei, uffici governativi). |

3. Regione Veneto

Costruzione di un ponte a Venezia

| Dettaglio | Informazione |

|---|---|

| Scadenza offerte | 3 luglio 2024 |

| Importo a base d’asta | 4 milioni di euro |

| Descrizione | Realizzazione di un nuovo ponte per facilitare il traffico pedonale e veicolare, inclusa l’installazione di infrastrutture complementari come illuminazione e sistemi di sicurezza. |

4. Regione Campania

Ampliamento di un ospedale a Napoli

| Dettaglio | Informazione |

|---|---|

| Scadenza offerte | 1 luglio 2024 |

| Importo a base d’asta | 10 milioni di euro |

| Descrizione | Espansione di un ospedale esistente con la costruzione di nuovi reparti e strutture di servizio. Include aggiornamento delle attrezzature mediche e integrazione di tecnologie sanitarie avanzate. |

5. Regione Sicilia

Ristrutturazione di una scuola secondaria a Palermo

| Dettaglio | Informazione |

|---|---|

| Scadenza offerte | 5 luglio 2024 |

| Importo a base d’asta | 2 milioni di euro |

| Descrizione | Interventi di miglioramento sismico ed efficientamento energetico per una scuola secondaria esistente, rendendo l’edificio più sicuro e sostenibile. |

Questi appalti rappresentano significative opportunità per le imprese edili, sia per il valore economico che per l’impatto sulle comunità locali. Per ulteriori dettagli e partecipare alle gare, gli interessati possono consultare portali specializzati come il Portale delle Gare d’Appalto del Ministero delle Infrastrutture e dei Trasporti.

Utilizzando queste risorse, le imprese possono filtrare le gare per regione, tipologia di lavoro e scadenza, facilitando così la partecipazione agli appalti più rilevanti per le loro competenze e capacità.

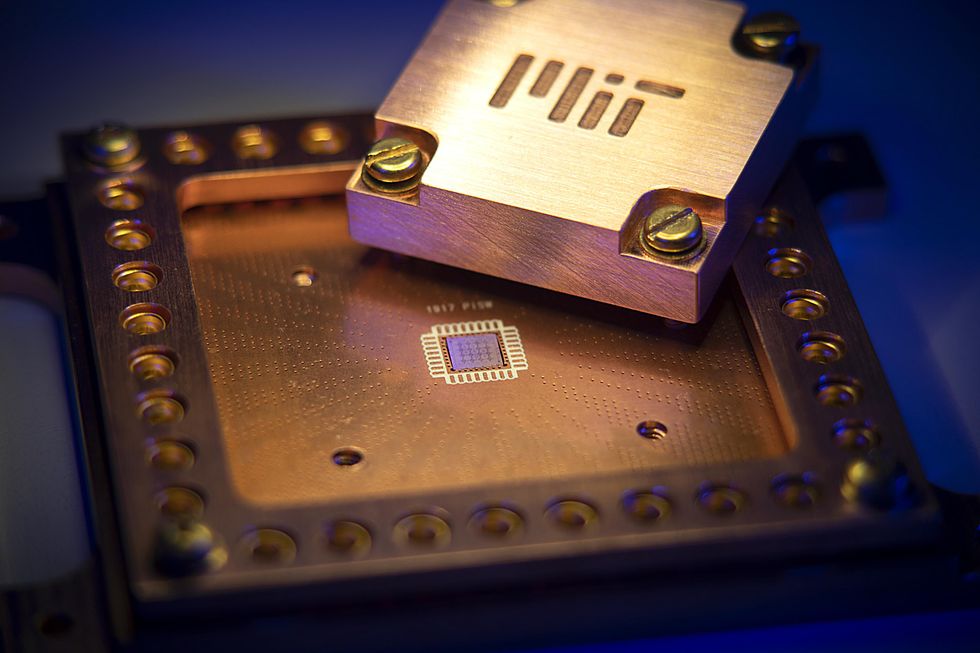

Materiali atomicamente sottili riducono significativamente i qubit

La computazione quantistica è una tecnologia estremamente complessa, con molte sfide tecniche che ne influenzano lo sviluppo. Di queste sfide, due questioni critiche emergono: la miniaturizzazione e la qualità dei qubit.

IBM ha adottato la roadmap dei qubit superconduttori per raggiungere un processore da 1.121 qubit entro il 2023, portando all’aspettativa che 1.000 qubit con l’attuale fattore di forma dei qubit siano fattibili. Tuttavia, gli approcci attuali richiederanno chip molto grandi (50 millimetri per lato, o più grandi) alla scala di piccole fette, o l’uso di chiplet su moduli multichip. Sebbene questo approccio funzionerà, l’obiettivo è raggiungere un percorso migliore verso la scalabilità.

Adesso i ricercatori del MIT sono stati in grado di ridurre le dimensioni dei qubit e lo hanno fatto in modo da ridurre le interferenze che si verificano tra i qubit vicini. I ricercatori del MIT hanno aumentato il numero di qubit superconduttori che possono essere aggiunti a un dispositivo di un fattore di 100.

“Stiamo affrontando sia la miniaturizzazione dei qubit che la qualità,” ha dichiarato William Oliver, direttore del Centro per l’Ingegneria Quantistica al MIT. “A differenza della scalabilità dei transistor convenzionali, dove conta solo il numero, per i qubit, grandi numeri non sono sufficienti, devono anche essere ad alte prestazioni. Sacrificare le prestazioni per il numero di qubit non è uno scambio utile nella computazione quantistica. Devono andare di pari passo.”

La chiave di questo grande aumento della densità dei qubit e della riduzione delle interferenze risiede nell’uso di materiali bidimensionali, in particolare l’isolante bidimensionale nitruro di boro esagonale (hBN). I ricercatori del MIT hanno dimostrato che pochi monolayer atomici di hBN possono essere impilati per formare l’isolante nei condensatori di un qubit superconduttore.

Come altri condensatori, i condensatori in questi circuiti superconduttori assumono la forma di un sandwich in cui un materiale isolante è interposto tra due piastre metalliche. La grande differenza per questi condensatori è che i circuiti superconduttori possono funzionare solo a temperature estremamente basse – meno di 0,02 gradi sopra lo zero assoluto (-273,15 °C).

I qubit superconduttori vengono misurati a temperature inferiori a 20 millikelvin in un frigorifero a diluizione.Nathan Fiske/MIT

In quell’ambiente, i materiali isolanti disponibili per il compito, come il biossido di silicio PE-CVD o il nitruro di silicio, presentano parecchi difetti troppo dissipativi per le applicazioni di computazione quantistica. Per aggirare questi difetti dei materiali, la maggior parte dei circuiti superconduttori utilizza i cosiddetti condensatori coplanari. In questi condensatori, le piastre sono posizionate lateralmente l’una rispetto all’altra, piuttosto che una sopra l’altra.

Come risultato, il substrato di silicio intrinseco sotto le piastre e in misura minore il vuoto sopra le piastre fungono da dielettrico del condensatore. Il silicio intrinseco è chimicamente puro e quindi presenta pochi difetti, e le dimensioni grandi diluiscono il campo elettrico alle interfacce delle piastre, il che porta a un condensatore a bassa perdita. Le dimensioni laterali di ciascuna piastra in questo design a faccia aperta finiscono per essere piuttosto grandi (tipicamente 100 per 100 micrometri) per raggiungere la capacità richiesta.

Nel tentativo di allontanarsi dalla configurazione laterale grande, i ricercatori del MIT si sono impegnati nella ricerca di un isolante che abbia pochi difetti e sia compatibile con le piastre del condensatore superconduttore.

“Abbiamo scelto di studiare l’hBN perché è l’isolante più ampiamente usato nella ricerca sui materiali 2D a causa della sua pulizia e inerzia chimica,” ha detto il coautore Joel Wang, un ricercatore scientifico nel gruppo di Ingegneria dei Sistemi Quantistici del Laboratorio di Ricerca Elettronica del MIT.

Sui lati dell’hBN, i ricercatori del MIT hanno utilizzato il materiale superconduttore 2D, diseleniuro di niobio. Uno degli aspetti più complicati della fabbricazione dei condensatori è stato lavorare con il diseleniuro di niobio, che si ossida in pochi secondi quando esposto all’aria, secondo Wang. Questo rende necessario che l’assemblaggio del condensatore avvenga in una scatola a guanto riempita con gas argon.

Sebbene questo sembrerebbe complicare la scalabilità della produzione di questi condensatori, Wang non considera questo un fattore limitante.

“Ciò che determina il fattore di qualità del condensatore sono le due interfacce tra i due materiali,” ha detto Wang. “Una volta che il sandwich è fatto, le due interfacce sono “sigillate” e non notiamo alcun degrado nel tempo quando esposte all’atmosfera.”

Questo mancato degrado è dovuto al fatto che circa il 90 percento del campo elettrico è contenuto nella struttura a sandwich, quindi l’ossidazione della superficie esterna del diseleniuro di niobio non gioca più un ruolo significativo. Questo rende alla fine l’ingombro del condensatore molto più piccolo, e spiega la riduzione delle interferenze tra i qubit vicini.

“La principale sfida per scalare la fabbricazione sarà la crescita su scala di wafer di hBN e superconduttori 2D come [diseleniuro di niobio], e come si può impilare su scala di wafer di questi film,” ha aggiunto Wang.

Wang ritiene che questa ricerca abbia dimostrato che l’hBN 2D sia un buon candidato isolante per i qubit superconduttori. Egli afferma che il lavoro preliminare svolto dal team del MIT servirà da guida per utilizzare altri materiali ibridi 2D per costruire circuiti superconduttori.

SEO Tecnico: Come gestire i file robots.txt in siti complessi

Capitolo 1: Introduzione ai file robots.txt

Sezione 1: Cos’è un file robots.txt?

Il file robots.txt è un file di testo che si trova nella radice di un sito web e serve a comunicare ai motori di ricerca quali pagine o risorse del sito non devono essere indicizzate o crawlate. Il file robots.txt è un protocollo standard utilizzato dai webmaster per fornire istruzioni ai crawler dei motori di ricerca, come Googlebot, Bingbot e altri, su come interagire con il loro sito web. (Fonte: https://www.robotstxt.org/)

Il file robots.txt è un file di testo semplice che contiene direttive per i crawler dei motori di ricerca. Ad esempio, una direttiva comune è “User-agent: *”, che indica che le istruzioni successive si applicano a tutti i crawler dei motori di ricerca. Altre direttive possono includere “Disallow: /”, che indica che il crawler non deve accedere a nessuna pagina del sito, o “Allow: /public/”, che indica che il crawler può accedere alle pagine nella directory “/public/”.

I file robots.txt sono utili per una serie di motivi. Ad esempio, possono essere utilizzati per evitare che pagine di amministrazione o altre aree del sito che non sono destinate agli utenti siano indicizzate nei motori di ricerca. Possono anche essere utilizzati per prevenire che risorse come immagini o file CSS siano caricati più volte, migliorando la performance del sito.

Tuttavia, è importante notare che i file robots.txt non sono una misura di sicurezza efficace per proteggere le informazioni sensibili. I crawler dei motori di ricerca possono ignorare le direttive del file robots.txt se lo desiderano, e gli utenti malintenzionati possono comunque accedere alle pagine o risorse del sito utilizzando altri metodi.

Sezione 2: Come funziona un file robots.txt?

Un file robots.txt funziona specificando le direttive per i crawler dei motori di ricerca. Le direttive possono essere di due tipi: “Disallow” e “Allow”. La direttiva “Disallow” specifica le pagine o risorse del sito che i crawler non devono accedere, mentre la direttiva “Allow” specifica le pagine o risorse che i crawler possono accedere.

Ad esempio, il seguente file robots.txt:“`User-agent: *Disallow: /admin/Allow: /public/“`indica che tutti i crawler dei motori di ricerca devono evitare la directory “/admin/” e possono accedere alle pagine nella directory “/public/”.

I file robots.txt possono anche contenere altre direttive, come “Crawl-delay”, che specifica il ritardo tra le richieste di crawl successive.

È importante notare che i file robots.txt devono essere collocati nella radice del sito web e devono essere accessibili tramite HTTP. Inoltre, i file robots.txt devono essere file di testo semplice, senza estensione.

Sezione 3: Esempi di file robots.txt

Ecco alcuni esempi di file robots.txt:“`User-agent: *Disallow: /“`Questo file robots.txt indica che tutti i crawler dei motori di ricerca devono evitare tutte le pagine del sito.“`User-agent: GooglebotDisallow: /admin/“`Questo file robots.txt indica che solo il crawler di Google deve evitare la directory “/admin/”.“`User-agent: *Allow: /public/“`Questo file robots.txt indica che tutti i crawler dei motori di ricerca possono accedere alle pagine nella directory “/public/”.

Sezione 4: Best practice per i file robots.txt

Alcune best practice per i file robots.txt includono:

- Collocare il file robots.txt nella radice del sito web.

- Utilizzare un file di testo semplice, senza estensione.

- Specificare le direttive per i crawler dei motori di ricerca in modo chiaro e conciso.

- Utilizzare la direttiva “Crawl-delay” per evitare di sovraccaricare il sito con richieste di crawl.

Capitolo 2: Gestione dei file robots.txt in siti complessi

Sezione 1: Sfide nella gestione dei file robots.txt in siti complessi

I siti web complessi possono avere molte pagine e risorse che devono essere gestite in modo efficace. La gestione dei file robots.txt in questi siti può essere difficile a causa della complessità delle strutture di directory e delle esigenze di crawl dei motori di ricerca.

Ad esempio, un sito e-commerce può avere molte categorie di prodotti e pagine di dettaglio prodotto che devono essere indicizzate nei motori di ricerca. Tuttavia, le pagine di amministrazione e le aree del sito che non sono destinate agli utenti devono essere escluse dal crawl.

Un’altra sfida è la gestione dei file robots.txt in siti con molte sottodirectory e risorse condivise. In questi casi, è importante assicurarsi che le direttive del file robots.txt siano applicate correttamente a tutte le aree del sito.

Infine, la gestione dei file robots.txt in siti complessi può richiedere la collaborazione tra più team e individui, come gli sviluppatori, i webmaster e gli specialisti SEO.

Sezione 2: Strategie per la gestione dei file robots.txt in siti complessi

Alcune strategie per la gestione dei file robots.txt in siti complessi includono:

- Utilizzare un file robots.txt centralizzato per gestire le direttive per tutti i crawler dei motori di ricerca.

- Utilizzare la direttiva “Include” per includere altri file robots.txt in aree specifiche del sito.

- Utilizzare strumenti di gestione dei file robots.txt per semplificare la gestione delle direttive.

- Collaborare con gli sviluppatori e gli specialisti SEO per assicurarsi che le direttive del file robots.txt siano allineate con le esigenze del sito.

Sezione 3: Strumenti per la gestione dei file robots.txt

Ci sono molti strumenti disponibili per aiutare nella gestione dei file robots.txt, come:

- Google Search Console: uno strumento gratuito che consente di gestire le direttive del file robots.txt e monitorare le prestazioni del sito nei motori di ricerca.

- Screaming Frog: uno strumento di crawl che consente di analizzare le strutture di directory e identificare le aree del sito che richiedono attenzione.

- Ahrefs: uno strumento di analisi SEO che consente di monitorare le prestazioni del sito nei motori di ricerca e identificare le opportunità di miglioramento.

Sezione 4: Best practice per la gestione dei file robots.txt in siti complessi

Alcune best practice per la gestione dei file robots.txt in siti complessi includono:

- Utilizzare un approccio centralizzato per la gestione dei file robots.txt.

- Collaborare con gli sviluppatori e gli specialisti SEO per assicurarsi che le direttive del file robots.txt siano allineate con le esigenze del sito.

- Utilizzare strumenti di gestione dei file robots.txt per semplificare la gestione delle direttive.

- Monitorare le prestazioni del sito nei motori di ricerca e ajustare le direttive del file robots.txt di conseguenza.

Capitolo 3: Impatto dei file robots.txt sulla SEO

Sezione 1: Come i file robots.txt influenzano la SEO

I file robots.txt possono avere un impatto significativo sulla SEO di un sito web. Le direttive del file robots.txt possono influenzare la capacità dei motori di ricerca di crawl e indicizzare le pagine del sito.

Ad esempio, se un file robots.txt blocca l’accesso a una pagina importante, potrebbe impedirne l’indicizzazione nei motori di ricerca. Ciò potrebbe avere un impatto negativo sulla visibilità del sito e sulla sua capacità di attrarre traffico organico.

D’altra parte, se un file robots.txt consente l’accesso a risorse non necessarie, potrebbe portare a una riduzione della qualità del crawl e a una diminuzione della rilevanza del sito nei motori di ricerca.

Pertanto, è importante assicurarsi che le direttive del file robots.txt siano configurate correttamente per garantire che le pagine importanti siano crawl e indicizzate correttamente.

Sezione 2: Strategie per ottimizzare i file robots.txt per la SEO

Alcune strategie per ottimizzare i file robots.txt per la SEO includono:

- Assicurarsi che le pagine importanti siano accessibili ai crawler dei motori di ricerca.

- Utilizzare la direttiva “Allow” per consentire l’accesso a risorse specifiche.

- Utilizzare la direttiva “Disallow” per bloccare l’accesso a risorse non necessarie.

- Monitorare le prestazioni del sito nei motori di ricerca e ajustare le direttive del file robots.txt di conseguenza.

Sezione 3: Strumenti per monitorare l’impatto dei file robots.txt sulla SEO

Ci sono molti strumenti disponibili per aiutare a monitorare l’impatto dei file robots.txt sulla SEO, come:

- Google Search Console: uno strumento gratuito che consente di monitorare le prestazioni del sito nei motori di ricerca e identificare le aree di miglioramento.

- Ahrefs: uno strumento di analisi SEO che consente di monitorare le prestazioni del sito nei motori di ricerca e identificare le opportunità di miglioramento.

- Screaming Frog: uno strumento di crawl che consente di analizzare le strutture di directory e identificare le aree del sito che richiedono attenzione.

Sezione 4: Best practice per l’ottimizzazione dei file robots.txt per la SEO

Alcune best practice per l’ottimizzazione dei file robots.txt per la SEO includono:

- Assicurarsi che le pagine importanti siano accessibili ai crawler dei motori di ricerca.

- Utilizzare la direttiva “Allow” per consentire l’accesso a risorse specifiche.

- Utilizzare la direttiva “Disallow” per bloccare l’accesso a risorse non necessarie.

- Monitorare le prestazioni del sito nei motori di ricerca e ajustare le direttive del file robots.txt di conseguenza.

Capitolo 4: Sicurezza e file robots.txt

Sezione 1: Rischi di sicurezza associati ai file robots.txt

I file robots.txt possono presentare alcuni rischi di sicurezza se non gestiti correttamente. Ad esempio, se un file robots.txt blocca l’accesso a una pagina importante, potrebbe impedirne la visualizzazione agli utenti autorizzati.

Inoltre, se un file robots.txt consente l’accesso a risorse sensibili, potrebbe permettere agli utenti malintenzionati di accedere a informazioni sensibili.

Pertanto, è importante assicurarsi che le direttive del file robots.txt siano configurate correttamente per garantire la sicurezza del sito e dei suoi utenti.

Sezione 2: Strategie per proteggere la sicurezza dei file robots.txt

Alcune strategie per proteggere la sicurezza dei file robots.txt includono:

- Utilizzare la direttiva “Disallow” per bloccare l’accesso a risorse sensibili.

- Utilizzare la direttiva “Allow” per consentire l’accesso a risorse specifiche.

- Monitorare le prestazioni del sito e ajustare le direttive del file robots.txt di conseguenza.

- Utilizzare strumenti di sicurezza per monitorare l’attività del sito e identificare le minacce.

Sezione 3: Strumenti per proteggere la sicurezza dei file robots.txt

Ci sono molti strumenti disponibili per aiutare a proteggere la sicurezza dei file robots.txt, come:

- Google Search Console: uno strumento gratuito che consente di monitorare le prestazioni del sito nei motori di ricerca e identificare le aree di miglioramento.

- Ahrefs: uno strumento di analisi SEO che consente di monitorare le prestazioni del sito nei motori di ricerca e identificare le opportunità di miglioramento.

- Screaming Frog: uno strumento di crawl che consente di analizzare le strutture di directory e identificare le aree del sito che richiedono attenzione.

Sezione 4: Best practice per la protezione della sicurezza dei file robots.txt

Alcune best practice per la protezione della sicurezza dei file robots.txt includono:

- Utilizzare la direttiva “Disallow” per bloccare l’accesso a risorse sensibili.

- Utilizzare la direttiva “Allow” per consentire l’accesso a risorse specifiche.

- Monitorare le prestazioni del sito e ajustare le direttive del file robots.txt di conseguenza.

- Utilizzare strumenti di sicurezza per monitorare l’attività del sito e identificare le minacce.

Capitolo 5: Domande e risposte sui file robots.txt

Domanda 1: Cos’è un file robots.txt?

Un file robots.txt è un file di testo che si trova nella radice di un sito web e serve a comunicare ai motori di ricerca quali pagine o risorse del sito non devono essere indicizzate o crawlate.

Domanda 2: Come funziona un file robots.txt?

Un file robots.txt funziona specificando le direttive per i crawler dei motori di ricerca. Le direttive possono essere di due tipi: “Disallow” e “Allow”.

Domanda 3: Quali sono le best practice per la gestione dei file robots.txt?

Alcune best practice per la gestione dei file robots.txt includono: collocare il file robots.txt nella radice del sito web, utilizzare un file di testo semplice, specificare le direttive per i crawler dei motori di ricerca in modo chiaro e conciso.

Domanda 4: Come posso proteggere la sicurezza dei miei file robots.txt?

Alcune strategie per proteggere la sicurezza dei file robots.txt includono: utilizzare la direttiva “Disallow” per bloccare l’accesso a risorse sensibili, utilizzare la direttiva “Allow” per consentire l’accesso a risorse specifiche, monitorare le prestazioni del sito e ajustare le direttive del file robots.txt di conseguenza.

Domanda 5: Quali sono gli strumenti disponibili per gestire i file robots.txt?

Ci sono molti strumenti disponibili per aiutare a gestire i file robots.txt, come: Google Search Console, Ahrefs, Screaming Frog.

Capitolo 6: Curiosità sui file robots.txt

I file robots.txt sono un argomento interessante e possono essere utilizzati in modi creativi per gestire l’accesso ai siti web.

Ad esempio, alcuni siti web utilizzano i file robots.txt per bloccare l’accesso ai crawler dei motori di ricerca durante le manutenzioni o gli aggiornamenti.

Altri siti web utilizzano i file robots.txt per consentire l’accesso a risorse specifiche solo a determinati crawler o utenti.

In generale, i file robots.txt sono uno strumento utile per gestire l’accesso ai siti web e possono essere utilizzati in modi diversi per soddisfare le esigenze specifiche.

Capitolo 7: Aziende e scuole per imparare sui file robots.txt

Ci sono molte aziende e scuole che offrono corsi e formazione sui file robots.txt e sulla gestione dei siti web.

Alcune aziende che offrono servizi di gestione dei siti web e di ottimizzazione per i motori di ricerca includono:

Alcune scuole che offrono corsi di formazione sui file robots.txt e sulla gestione dei siti web includono:

Capitolo 8: Opiniione e proposta di alternative

I file robots.txt sono uno strumento utile per gestire l’accesso ai siti web, ma possono anche presentare alcuni limiti e sfide.

Ad esempio, i file robots.txt possono essere facilmente aggirati da utenti malintenzionati o da crawler dei motori di ricerca che non rispettano le direttive.

Inoltre, i file robots.txt possono anche limitare l’accesso a risorse importanti per gli utenti legittimi.

Pertanto, è importante considerare alternative ai file robots.txt, come ad esempio:

- Utilizzare sistemi di autenticazione e autorizzazione per controllare l’accesso alle risorse.

- Utilizzare tecnologie di crittografia per proteggere le risorse sensibili.

- Utilizzare strumenti di monitoraggio e analisi per identificare e rispondere alle minacce.

Capitolo 9: Conclusione

I file robots.txt sono uno strumento importante per gestire l’accesso ai siti web e possono essere utilizzati in modi diversi per soddisfare le esigenze specifiche.

Tuttavia, è importante considerare anche le sfide e i limiti dei file robots.txt e esplorare alternative per garantire la sicurezza e la gestione efficace dei siti web.

In generale, la gestione dei file robots.txt richiede una comprensione approfondita delle esigenze del sito web e delle tecnologie utilizzate per gestirlo.

Spero che questo articolo abbia fornito informazioni utili sulla gestione dei file robots.txt e sulla loro importanza nella gestione dei siti web.

Il Premio Architettura Toscana è rivolto a tutti gli architetti, ingegneri, designer e professionisti del settore che operano sul territorio toscano, con l’obiettivo di valorizzare le eccellenze e le innovazioni nel campo dell’architettura contemporanea. La partecipazione al concorso è gratuita e aperta a progetti realizzati o in corso di realizzazione sul territorio toscano, che siano stati completati entro il 31 dicembre 2021.

Le categorie in cui è possibile concorrere sono diverse e comprendono, ad esempio, edifici residenziali, edifici pubblici, ristrutturazioni, progetti di rigenerazione urbana, progetti di architettura del paesaggio e molto altro ancora. I progetti saranno valutati da una giuria di esperti del settore, che premierà le opere più significative e innovative.

La scadenza per la presentazione dei progetti è fissata per il 31 marzo 2022 e la premiazione dei vincitori avverrà in una cerimonia ufficiale che si terrà a Firenze. I progetti selezionati saranno esposti in una mostra itinerante che toccherà diverse città toscane, contribuendo così a diffondere la cultura dell’architettura e del design nel territorio.

Il Premio Architettura Toscana rappresenta un’importante opportunità per mettere in luce il talento e la creatività degli architetti toscani, contribuendo a promuovere la qualità e l’innovazione nel settore dell’architettura nella regione.